深入解析美超微與輝達的戰略合作,了解Blackwell伺服器如何為AI與HPC帶來革命性改變。

現狀

美超微電腦在其 Nvidia Blackwell GPU 供應和業務關係方面正面臨重大挑戰。據報導,Nvidia 已開始將訂單從 SMCI 轉向更穩定的供應商,影響了他們的合作夥伴關係。

技術準備

儘管面臨挑戰,美超微聲稱已為 Blackwell 的部署做好技術準備:

- 他們的 GB200 NVL72 系統已準備就緒

- 風冷式 10U B200 和液冷式 4U 系統均已準備好量產

潛在問題

有幾個因素正在影響這種關係:

法律和財務方面的擔憂

- 司法部對其財務行為的調查

- 安永辭去審計師的職務

- 納斯達克退市的風險

- 財務不當行為的指控

供應鏈影響

- Blackwell 晶片的供應有限

- 執行長梁見後承認持續向 Nvidia 請求新的 Blackwell 晶片供應

- 預計第一季產量可能會有所改善

市場影響

這種情況為競爭對手創造了機會:

- 戴爾成為受益者,報告了 31 億美元的 AI 伺服器銷售額

- 戴爾的基礎架構解決方案事業群的伺服器銷售額增長了 80%

- Alphabet、亞馬遜和微軟等主要科技公司預計將在 2025 年收到首批 Blackwell 產品

美超微的 Blackwell 伺服器合約的未來仍然不確定,因為 Nvidia 似乎正在優先考慮其晶片供應鏈中更穩定的合作夥伴。

Nvidia Blackwell 伺服器的主要供應商有哪些

| 供應商 | 市佔率 (%) |

|---|---|

| 鴻海科技集團 (富士康) | 24 |

| 英業達 | 22 |

| 廣達電腦 | 15 |

| 緯創 | 5 |

| 技嘉 | 2 |

| 緯穎 | 1 |

要點

供應鏈角色

- 富士康以其垂直整合能力領先,負責 GPU 模組、基板、主機板和機殼

- 廣達電腦以擁有最先進的技術而聞名,並設計了第一台搭載 Nvidia 的 AI 伺服器

- 英業達是微軟最大的 AI 伺服器主機板供應商

- 緯創是 Nvidia DGX 伺服器的獨家製造商

市場地位

- 台灣廠商佔 Nvidia 全球 GPU 伺服器出貨量的 70% 以上

- 這些供應商透過以下方式獲得競爭優勢:

- 規模經濟

- 靈活的全球生產網絡

- 在台灣、東南亞和墨西哥的生產能力

預計 2024 年第四季即將推出的 Blackwell 平台將推動伺服器市場的重大變革,尤其是在冷卻解決方案方面,液冷滲透率預計將從 2024 年的 10% 增長到 2025 年的 20% 以上。

美超微電腦與 Nvidia 在 AI 伺服器,特別是 Blackwell 方面的策略合作夥伴關係是什麼

產品組合

支援 Blackwell 的系統

- NVIDIA HGX B100/B200 8-GPU 系統

- 4U 液冷式 NVIDIA HGX B200 8-GPU 系統

- GB200 NVL72 機架解決方案,配備 72 個 NVIDIA Blackwell GPU

- 10U 風冷式 B200 系統

- 支援最多 4 個 B100 GPU 的各種 MGX 系統

技術創新

冷卻解決方案

- 適用於高 TDP GPU 的直接晶片液冷技術

- 機架式液冷解決方案,可將功耗降低高達 40%

- SuperCloud Composer (SCC) 適用於從晶片到冷卻塔的端到端管理

效能

- 與 Hopper 架構相比,系統為大型語言模型的訓練速度提高了 3 倍

- 1.8TB/s 高速第五代 NVLink 互連

- 與 HGX H100 相比,AI 推理速度提高了 30 倍

製造能力

- 每月 5,000 個機架的生產能力

- Blackwell 部署的先發制人策略

- 以世界一流的效率進行全球製造

目前的挑戰

儘管技術上已準備就緒,但美超微仍面臨一些障礙:

- 財務報告延遲和審計師辭職

- 司法部調查的擔憂

- Blackwell 晶片供應的不確定性

- 執行長梁見後積極尋求 Nvidia 增加晶片分配

未來展望

- 專注於機架式全液冷解決方案

- 強調模組化架構和適用於 AI 的機架式 Total IT

- 已準備好生產,但等待 Nvidia 的晶片供應

- 預計 2025 年第一季產量將有所改善

美超微的液冷技術如何提升 NVIDIA Blackwell GPU 的效能

技術能力

冷卻效能

- 處理每台伺服器高達 12kW 的極端熱量

- 管理產生超過 100kW 熱量的 AI 機架

- 支援高達 113°F (45°C) 的溫水冷卻

- 可為下一代 NVIDIA GPU 散發高達 1600W 的熱量

系統密度

- 每個機架最多可容納 96 個 NVIDIA Blackwell GPU

- 與傳統設置相比,運算密度提高了 4 倍

- 在 GB200 NVL72 配置中支援最多 72 個 NVIDIA Blackwell GPU

效率提升

電源和空間最佳化

- 將功耗降低高達 40%

- 透過消除傳統的 CRAC/CRAH 單元,節省 80% 的空間

- PUE 低於 1.1

效能優勢

- 允許 GPU 在更長時間內以峰值效能運行

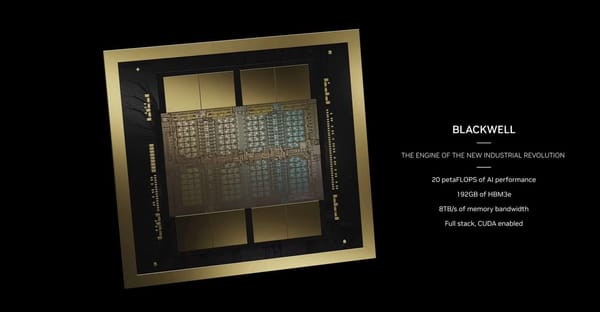

- 在單個 GPU 上實現 20 PetaFLOPS 的完全利用

- 縮短大型語言模型的訓練時間

基礎架構組件

完整的冷卻解決方案

- 具有微通道的先進冷板

- 冷卻液分配單元 (CDU),冷卻能力為 250kW

- 水平和垂直冷卻液分配歧管 (CDM)

- 採用 EC 風扇技術的模組化冷卻塔

- SuperCloud Composer 管理軟體,用於即時監控

這種全面的液冷解決方案已被證明是成功的,自 2024 年 6 月以來,美超微已部署了超過 2000 個液冷機架,證明了其在實際 AI 基礎架構項目中的有效性。

Nvidia 關於 Blackwell 伺服器過熱的新原因,並要求其供應商更改設計,請給我一個摘要

根據最近的新聞報導(2024 年 11 月 17 日至 18 日),以下是 Nvidia Blackwell 伺服器過熱情況的摘要:

核心問題

過熱問題

- Blackwell GPU 在安裝到 72 晶片伺服器機架中時,會遇到嚴重的散熱管理問題

- 設計用於消耗高達 120kW 電力的機架顯示出熱管理方面的挑戰

設計修改

- Nvidia 已要求供應商對伺服器機架進行多項設計更改

- 修改發生在生產過程的後期

- 該公司正在與雲端服務供應商合作解決這些問題

影響

客戶的擔憂

- 包括 Google、Meta 和微軟在內的主要客戶擔心部署時間表

- 一些客戶擔心他們沒有足夠的時間讓新的資料中心投入運作

Nvidia 的回應

- 公司發言人表示,這些「工程迭代是正常且預期的」

- 將 GB200 系統描述為「有史以來最先進的電腦」

- 作為工程流程的一部分,繼續與領先的雲端服務供應商合作

時間表

- 於 2024 年 10 月下旬開始量產

- 預計於 2024 年 12 月開始首次交貨

- 軟銀被宣佈為第一個接收 Blackwell 晶片的客戶

這種情況影響了 Nvidia 的股價,新聞發布後股價下跌了 1.8%。

這些過熱問題對 Nvidia 股價的潛在影響是什麼

以下是過熱問題對 Nvidia 股價影響的分析:

立即的市場反應

股價影響

- 盤前交易中股價下跌高達 3% 至 137.92 美元

- 新聞發布後股價下跌了 1.8%

- 市值為 3.48 兆美元,仍然保持著全球市值最高公司的的地位

財務影響

收益預期

- 預計第三季收益將比去年同期增長 81%,達到 328 億美元

- 預計 1 月份的季度將有數十億美元的 Blackwell 營收

- 儘管目前面臨挑戰,但今年迄今股價已上漲 186.7%

市場擔憂

主要風險因素

- 可能延遲向 Meta、微軟和 Google 等主要客戶部署

- 生產時間表的變化影響 2024 年第四季的營收預測

- 由於多次機架重新設計而增加的工程成本

分析師觀點

市場展望

- 歷史數據顯示,收益前後一天的波動幅度可能高達 8.78%

- 前幾個季度的平均每股盈餘 (EPS) 意外值為 14.41%

- 儘管存在技術挑戰,分析師仍維持強烈的買入建議

長期考量

策略地位

- 預計到 2026 年市佔率將達到 66%

- 對 AI 基礎架構的持續強勁需求

- 執行長黃仁勳報告稱 Blackwell 的需求「瘋狂」

- 據報導,Blackwell 晶片在未來 12 個月內已售罄

市場的最終反應將在很大程度上取決於 Nvidia 多快能夠解決這些技術挑戰並維持其對主要客戶的預計交貨時間表。

美超微電腦與 Nvidia 在 Blackwell 伺服器方面的關係如何

以下是美超微電腦與 Nvidia 在 Blackwell 伺服器方面的關係的綜合分析:

策略合作夥伴關係

產品組合

- 多個基於 Blackwell 的系統正在開發中:

- NVIDIA GB200 NVL72 平台(每個機架 72 個 Blackwell GPU)

- 4U 液冷式 NVIDIA HGX B200 8-GPU 系統

- 10U 風冷式 B200 系統

- 採用 GB200 的 NVIDIA MGX 系統

製造能力

- 每月 5,000 個機架的全球生產能力

- 自 2024 年 6 月以來已出貨超過 2000 個液冷機架

- Blackwell 部署的先發制人策略

技術創新

冷卻解決方案

- 端到端液冷技術

- 先進的機架內或列內冷卻液分配單元 (CDU)

- 適用於運算托盤的客製化冷板

- SuperCloud Composer (SCC) 適用於從晶片到冷卻塔的管理

效能

- 1.8TB/s 第五代 NVLink 互連

- 與 Hopper 架構相比,大型語言模型的訓練速度提高了 3 倍

- 與 HGX H100 相比,AI 推理速度提高了 30 倍

目前的挑戰

供應鏈問題

- 積極尋求 Nvidia 增加晶片分配

- 執行長梁見後要求每日更新 Blackwell 的供應情況

- 預計 2025 年第一季產量將有所改善

未來展望

準備好擴展

- 系統已準備好生產,等待晶片供應

- 開發了增強的機架式解決方案

- 專注於模組化架構和適用於 AI 的機架式 Total IT

與其他競爭對手相比,美超微在 Nvidia AI 伺服器中的百分比是多少

以下是 Nvidia AI 伺服器市場的市佔率明細:

| 公司 | 目前市佔率 (%) | 預計到 2026-2027 年的市佔率 (%) |

|---|---|---|

| 美超微電腦 | 10 | 17 |

| 戴爾科技 | 35 | 未指定 |

| 惠普 | 25 | 未指定 |

| 其他 OEM | 30 | 未指定 |

主要市場動態

增長指標

- 美超微在 2024 財年的營收增長了 110%

- 與 AI 相關的銷售額佔美超微營收的 70%

- 每月 5,000 個機架的生產能力

競爭優勢

- 專精於液冷伺服器

- 直接晶片液冷技術

- Blackwell 部署的先發制人策略

- 美國銀行預計美超微的市佔率將在未來三年內增長到 17%

市場地位

- 目前控制著約 10% 的專用 AI 伺服器市場

- 面臨來自戴爾和惠普的激烈競爭

- 與 Nvidia 建立 GPU 供應的策略合作夥伴關係

- 已準備好生產 GB200 NVL72 和 B200 系統

市佔率百分比表明,雖然美超微目前是一個較小的參與者,但它在 AI 伺服器市場中具有顯著的增長潛力。

與其他競爭對手相比,美超微在 Nvidia AI 伺服器中的優勢是什麼

以下是美超微在 AI 伺服器市場中與競爭對手相比的主要優勢:

技術優勢

冷卻創新

- 液冷伺服器技術的領導者

- 先進的液冷技術可將功耗降低高達 40%

- 適用於高效能 AI 系統的專業解決方案

- 能夠處理每台伺服器高達 12kW 的極端熱量

產品差異化

- 高效能液冷伺服器作為利基市場

- 與 Nvidia 建立 GPU 整合的優先合作夥伴地位

- 早期獲得下一代 GPU 技術

- 靈活且客製化的方式來滿足客戶需求

市場地位

增長指標

- 2024 財年的營收增長了 110%

- AI 伺服器佔總營收的 50% 以上

- 目前 10% 的市佔率預計在未來三年內達到 17%

- 全球第四大伺服器供應商,領先於聯想

策略合作夥伴關係

- 與所有主要晶片供應商的密切合作:

- Nvidia(主要合作夥伴)

- AMD

- 英特爾

客戶群

主要客戶

- Meta

- 亞馬遜

- 主要雲端服務供應商

- 企業資料中心

競爭優勢

商業模式的優勢

- 更快的產品上市時間

- 更靈活且客製化的解決方案

- 節能設計

- 比大型競爭對手更低的價格

- 比戴爾和惠普更高的增長率

這種技術創新、策略合作夥伴關係和市場地位的結合,幫助美超微在 AI 伺服器市場中建立了強大的影響力,儘管面臨來自較大廠商的競爭。

美超微的液冷伺服器技術的優勢是什麼

以下是美超微液冷伺服器技術優勢的綜合分析:

技術優勢

冷卻效能

- 處理每台伺服器高達 12kW 的極端熱量

- 支援產生超過 100kW 熱量的 AI 機架

- 基礎架構節能高達 40%

- PUE 低於 1.1

基礎架構創新

- 完整的端到端液冷解決方案

- 具有微通道的先進冷板

- 配備 250kW 冷卻能力的最先進的機架式 CDU 解決方案

- 支援高達 113°F (45°C) 的溫水冷卻

市場領導地位

部署規模

- 自 2024 年 6 月以來已出貨超過 2000 個液冷機架

- 目前每季出貨超過 100,000 個 GPU

- 每月 5,000 個機架的生產能力

系統密度

- 每個機架最多可支援 96 個 NVIDIA B200 GPU

- 與傳統設置相比,運算密度提高了 4 倍

- 透過消除傳統的 CRAC/CRAH 單元,節省 80% 的空間

管理能力

軟體整合

- SuperCloud Composer 適用於端到端管理

- 所有組件的即時監控

- 整合的生命週期管理

- 營運成本的最佳化

競爭優勢

市場地位

- 只有聯想的 Neptune 解決方案可以相提並論

- 更快的部署速度(數週與數月)

- 適用於大型 AI 工作負載的更具針對性的冷卻解決方案

- 在高效能資料中心基礎架構中的領先地位

這種全面的解決方案使美超微成為快速增長的液冷伺服器市場中的領導者,尤其是在 AI 和高效能運算應用方面。

美超微如何確保其液冷系統的可靠性和效率

以下是美超微如何確保其液冷系統的可靠性和效率的詳細分析:

測試和驗證

多層級測試

- 在三個層級進行完全驗證和測試:

- 系統層級 (L10)

- 機架層級 (L11)

- 叢集層級 (L12)

- 具有備援系統的企業級組件

安全特性

- 防漏連接器

- 先進的洩漏檢測系統

- 單手操作、零滴漏快速斷開連接器

- 備援冷卻泵和電源

技術規格

冷卻能力

- 每台伺服器處理高達 12kW 的熱量

- 支援產生超過 100kW 熱量的機架

- 冷卻液分配單元,冷卻能力為 250kW

- 支援高達 113°F (45°C) 的溫水冷卻

組件設計

- 具有微通道的最佳化冷板

- 先進的熱阻降低

- 熱點消除技術

- 具有安全連接的彈性軟管

管理系統

SuperCloud Composer 軟體

- 所有組件的即時監控

- 端到端管理能力

- 從 CPU/GPU 到冷卻塔的溫度追蹤

- 效能健康的詳細記錄指標

- 預防性維護追蹤

經過驗證的效能

部署記錄

- 自 2024 年 6 月以來已交付超過 2,000 個液冷機架

- 目前每季出貨超過 100,000 個 GPU

- 成功冷卻了一些最大的 AI 設施

- 部署時間從數月縮短至數週

- 在實際應用中降低高達 40% 的功耗