Nvidia Blackwell 架構的推出,將為 AI 產業帶來革命性的變革,推動各行業的數位轉型。

Nvidia Blackwell 發布時間

根據目前的資訊,Nvidia Blackwell GPU 系列預計將在以下時間發布:

- 預計發布時間:2025年第一季度,很可能在2025年1月的CES消費電子展上首次亮相

- 之前有傳聞可能在2024年底發布,但現在看來已經延後到2025年初

- Nvidia已經開始向主要合作夥伴提供Blackwell樣品,包括Microsoft Azure和Oracle等

Blackwell對Nvidia的預期影響

- 銷售預測:

- Morgan Stanley分析師預測2024年第三季度Blackwell芯片銷售額將達到50-60億美元

- Nvidia表示Blackwell的需求非常強勁,未來12個月的供應已經售罄

- 收入增長:

- 分析師預計2025財年Nvidia銷售額增長40%,最高可能達到100%

- Blackwell可能為Nvidia在2025財年帶來800-1200億美元的增量收入

- 市場地位:

- Blackwell預計將進一步鞏固Nvidia在AI芯片市場的領導地位

- 新一代Blackwell架構將為客戶提供更強大的AI計算能力

- 生產狀況:

- Nvidia CEO黃仁勳表示Blackwell已進入"全面生產"階段

- 公司正在努力擴大供應以滿足強勁需求

- 潛在挑戰:

- 有報導稱Blackwell服務器存在過熱問題,但Nvidia表示這是正常的工程迭代過程

- 初期毛利率可能會下降到70%左右,但預計後續會回升到75%左右

總的來說,儘管面臨一些挑戰,Blackwell系列的推出預計將為Nvidia帶來可觀的收入增長,並進一步鞏固其在AI芯片市場的領導地位。

How does the Blackwell architecture differ from previous Nvidia GPUs

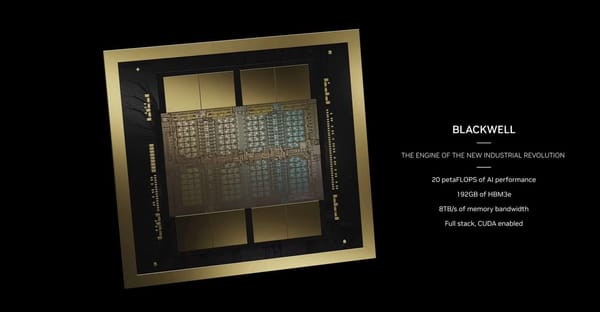

主要架構改進

晶片規格:

- Blackwell 採用 TSMC 4NP 製程,包含 2080 億個電晶體

- 採用雙晶片設計,透過每秒 10TB 的晶片對晶片連結整合為單一 GPU

- TDP 功耗達到 1000W,較 Hopper 的 700W 更高

效能提升

AI 運算能力:

- FP8 精度下可達到 20 PFLOPS,是 Hopper 的 2.5 倍

- FP4 新精度下可達到 40 PFLOPS,是 Hopper 的 5 倍

- 支援高達 7400 億參數的模型規模,是 Hopper 的 6 倍

記憶體規格:

- 配備 HBM3E 高頻寬記憶體,頻寬達到 34TB/s,是 Hopper 的 5 倍

- B200 配備 192GB 記憶體,使用 8 組 HBM3E 堆疊

新功能與技術

第二代 Transformer 引擎:

- 支援 4-bit 浮點運算推理能力

- 提供更高效的 AI 訓練與推理效能

安全性與可靠性:

- 新增專用的 RAS 引擎,可提前識別潛在故障

- 強化 AI 模型與資料保護的機密運算能力

互連技術:

- 第五代 NVLink,提供 1.8TB/s 雙向傳輸速度

- 可支援多達 576 個 GPU 互連,而 Hopper 僅支援 256 個

實際應用效益

能源效率:

- 訓練 1.8 萬億參數模型時,僅需 2000 個 Blackwell GPU 與 4MW 電力

- 相比之下,Hopper 需要 8000 個 GPU 與 15MW 電力

效能提升:

- 在 LLM 訓練測試中,每個 GPU 相較 Hopper 提升了 2.2 倍效能

- GPT-3 預訓練效能提升一倍,Llama 2 70B 微調效能提升 2.2 倍

Who is buying Blackwell chip from Nvidia

Blackwell 晶片主要買家

Nvidia 的 Blackwell 系列 GPU 晶片受到市場熱烈歡迎,主要買家包括:

- 科技巨頭

- Microsoft

- Meta (Facebook)

- Amazon

- Oracle

- 雲端服務提供商

- Amazon Web Services (AWS)

- CoreWeave

- 電信與投資公司

- SoftBank Group:成為首位 Blackwell 晶片客戶,計劃在日本建立 AI 超級電腦

- AI 研究機構

- OpenAI

需求情況

- Nvidia CEO 黃仁勳表示,Blackwell 晶片的需求「瘋狂」,未來 12 個月的供應已全數售罄

- 客戶訂單規模從上一代 Hopper 的數萬片,增加到 Blackwell 的數十萬片

- 分析師預計 2024 年第四季 Blackwell 晶片銷售額可達數十億美元

供應挑戰

- 由於需求激增,新客戶可能需要等待一年以上才能獲得 Blackwell 晶片

- Nvidia 正與 TSMC 合作擴大產能,以滿足持續增長的需求

- 記憶體供應可能成為限制因素,特別是高頻寬 HBM3E 記憶體的供應情況

總體而言,Blackwell 晶片的強勁需求反映了 AI 產業的蓬勃發展,主要科技公司正積極擴充其 AI 運算能力。

Are there any known issues with the Blackwell GPUs

已知問題概述

設計缺陷:

- 在 2024 年 8 月發現處理器晶片設計缺陷,導致良率偏低

- Nvidia CEO 黃仁勳承認這是「100% Nvidia 的問題」

- 問題已在 2024 年 8 月底獲得解決

過熱問題:

- 在 72 顆晶片的伺服器機架中出現嚴重過熱情況

- 每個機架功耗高達 120kW,導致效能限制和可能的硬體損壞風險

- Nvidia 已多次要求供應商重新設計伺服器機架以解決過熱問題

封裝技術挑戰:

- 使用 TSMC 的 CoWoS-L 封裝技術時遇到困難

- GPU 晶片、LSI 橋接、RDL 中介層和主機板基板之間的熱膨脹特性不匹配,導致結構變形

- 為改善良率,Nvidia 修改了 GPU 矽晶的頂層金屬層和凸塊結構

最新進展

問題解決狀況:

- 根據半導體分析師的報告,過熱問題已大致解決

- Semianalysis 的分析師認為這些問題被誇大了

- 量產已於 2024 年 10 月底開始,預計 2025 年 1 月開始出貨

影響範圍

- 主要影響客戶包括 Google、Meta 和 Microsoft 等大型科技公司

- 可能影響客戶的資料中心部署時程

- Oracle 已訂購 131,000 個 Blackwell GPU,但確切交付時間未定

誰是 Nvidia 的 HBM3E 供應商

Nvidia 的 HBM3E 供應商

Nvidia 目前的 HBM3E 記憶體晶片主要供應商包括:

- SK Hynix

- 為 Nvidia HBM3E 晶片的主要供應商

- 2024 年 3 月開始大規模供應 8 層 HBM3E 晶片

- 2024 年 9 月開始量產 12 層 HBM3E 晶片,容量達 36GB

- Micron Technology

- 2024 年 2 月開始量產 8 層 HBM3E 晶片

- 將為 Nvidia H200 Tensor Core GPU 提供 24GB HBM3E 記憶體

- Samsung Electronics

- 已通過 Nvidia 的 HBM3E 晶片認證測試

- 預計 2024 年第四季度開始供應 8 層 HBM3E 晶片

- 12 層 HBM3E 晶片仍在 Nvidia 認證測試中

供應情況

- SK Hynix 目前在 HBM 市場佔有 53% 的份額,領先其他競爭對手

- Micron 的加入為 HBM3E 市場帶來新的競爭

- Samsung 正努力追趕,預計將大幅提高 HBM 產量

未來發展

- 各供應商正積極開發下一代 HBM4 技術,預計 2026 年實現量產

- 競爭焦點將轉向更高層數、更大容量和更高效能的 HBM 產品