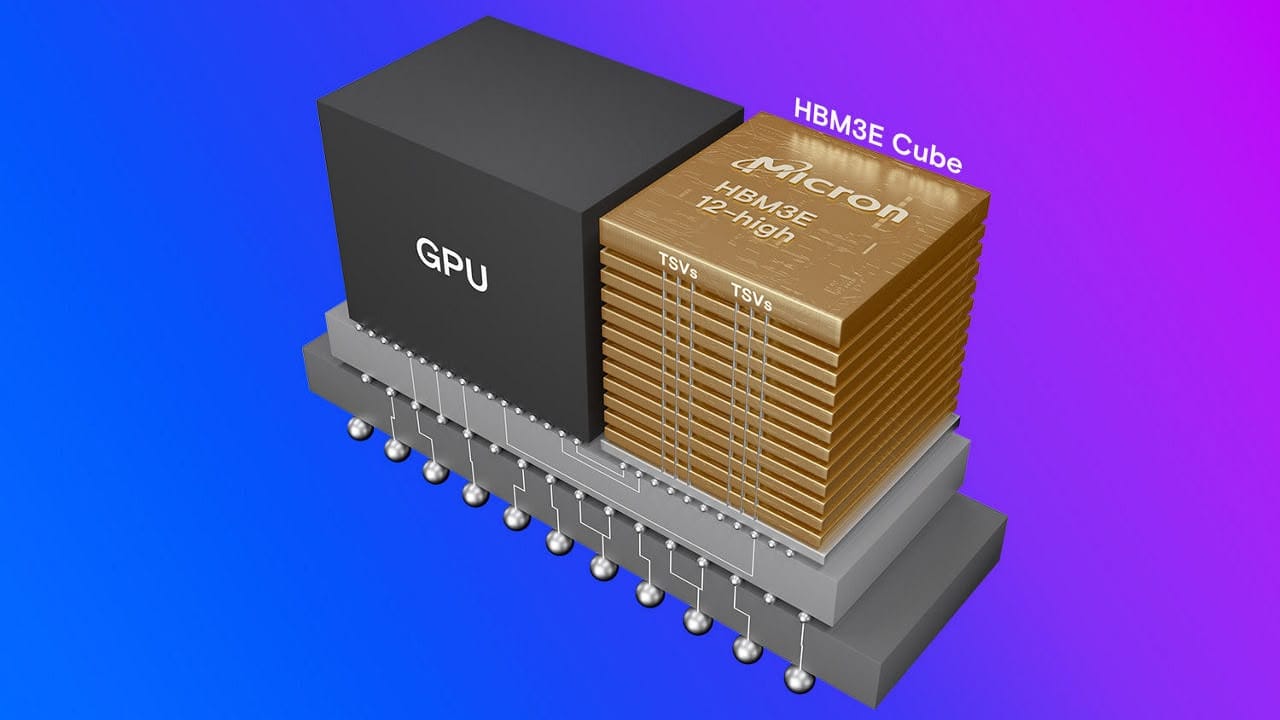

新記憶體是之前八層 24GB 模組的升級。

圖片來源:美光

美光宣布現已推出迄今速度最快、容量最高的高頻寬記憶體 (HBM),即第二代 HBM3,稱為 HBM3e。該公司最新的記憶體模組具有創紀錄的 36GB 儲存容量,較之前的 24GB 容量有了大幅升級。它透過將垂直堆疊的 3GB 晶片數量從 8 個增加到 12 個來實現這一壯舉。

美光錶示,它現在正在向「人工智慧生態系統」中的合作夥伴提供「可生產」的內存,這無疑是奇怪的措辭。這意味著記憶體將發送給 Nvidia 等合作夥伴,以獲得未來人工智慧加速器的資格。作為參考,即將推出的 Nvidia Blackwell B200 加速器使用每堆疊 24GB 內存,因此美光的這個新版本可能會在明年某個時候出現在 AI GPU 的升級版本中。

美光的路線圖顯示,直到 2026 年 HBM4 到來之前,12 層 HBM3e 將成為人工智慧的事實選擇。圖片來源:美光

美光錶示,儘管由於增加了四層內存,其 HBM3e 產品的容量增加了 50%,但與競爭對手的八層 HBM3e 產品相比,它的功耗降低了 30%。我們假設它指的是三星,儘管 SK 海力士也參與其中,因為它曾經是世界上最大的 HBM 供應商。總體而言,美光聲稱其 12 層、36GB 產品的每瓦效率比競爭對手高出 2.5W 以上。

三星和美光在 2 月發布了他們的 12 層 HBM3e 內存,因此從那時起,AMD、Nvidia 和其他專注於人工智慧的硬體供應商就一直在爭奪它。 AMD已經在考慮將目前的 MI300 系列 AI 加速器升級到 HBM3e,因為它隨 HBM3 一起推出,而Nvidia 也將其 H200 升級到了 HBM3e記憶體。正如我們上面所寫,Blackwell 將推出 HBM3e,但它也可能在某個時候從目前的 8 層設計升級到 12 層版本。

人們對人工智慧興趣的爆發使得高頻寬記憶體市場變得炙手可熱。作為需求的一個例子,美光和SK 海力士宣布,他們已經售出了2024 年和2025 年大部分時間的全部HBM 供應。會